"칩 전쟁은 끝났다"...AMD, 리사 수 "5년 내 컴퓨팅 100배 확장할 것"

요타플롭스 시대 개막…AMD 리사 수, "5년 내 컴퓨팅 100배로 확장할 것"

"칩 전쟁은 끝났다"...AMD, ‘3.2톤 헬리오스’로 AI 인프라 전쟁 선포

엔비디아의 폐쇄적 CUDA 겨냥?...AMD, ‘개방 생태계’로 판 흔든다

2000억 파라미터 PC 시대: AMD가 예고한 온디바이스 AI 혁명

AI를 모든 곳에 구현하려면 향후 5년 동안 전 세계 컴퓨팅 용량을 100배 늘려 10 요타플롭스(Yottaflops) 이상으로 만들어야 한다.리사 수, AMD

요타플롭스 시대 개막…AMD 리사 수, "5년 내 컴퓨팅 100배로 확장할 것"

AMD가 AI 시대 컴퓨팅 인프라의 새로운 척도를 제시했다.

1월 5일(현지시각), 리사 수 CEO는 라스베가스에서 개최된 CES2026 기조연설을 통해 향후 5년간 전 세계 컴퓨팅 용량을 10 요타플롭스(Yottaflops) 이상으로 확장해야 한다고 주장했다.

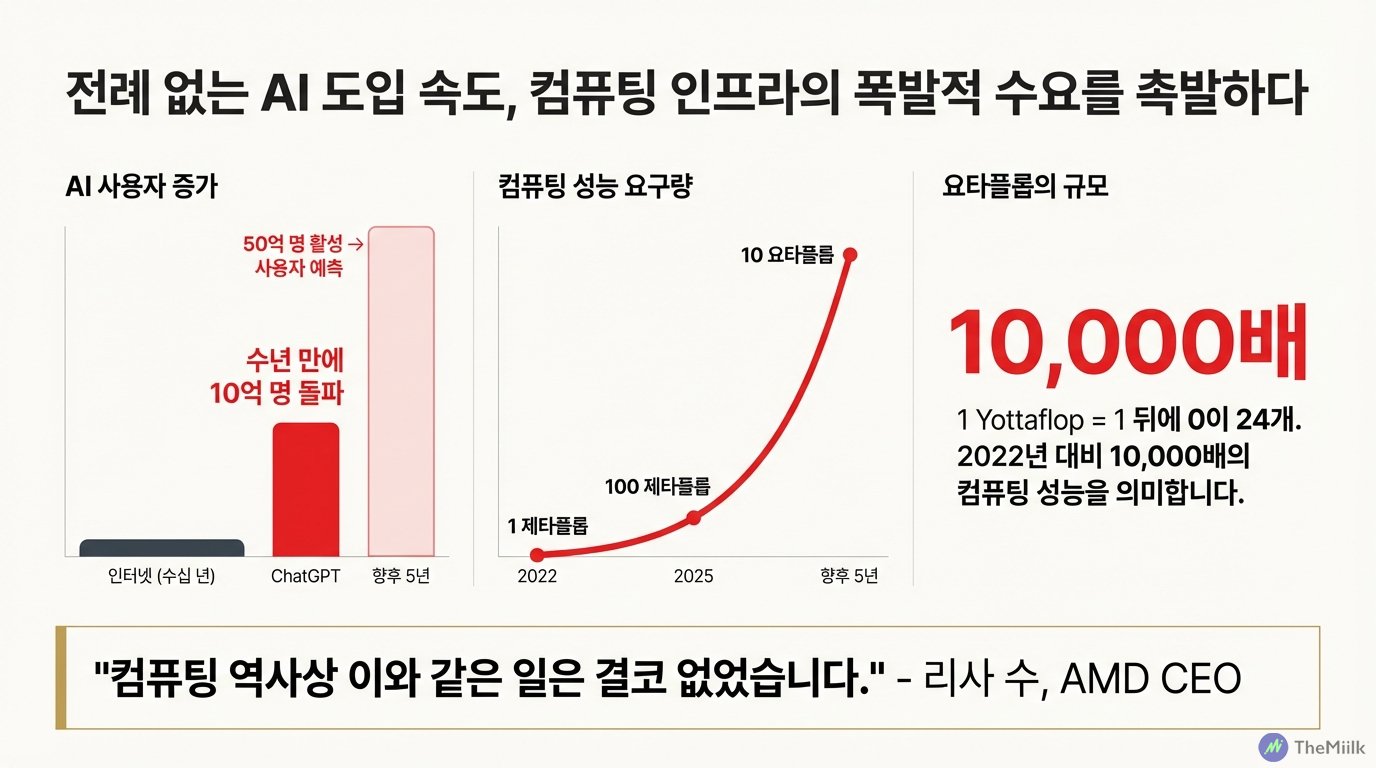

요타플롭스는 컴퓨팅 성능을 측정하는 단위로, 1초당 수행할 수 있는 연산 횟수를 의미한다. 이는 현재 전 세계 컴퓨팅 성능인 100 제타플롭스 대비 100배 수준으로 2022년과 비교하면 무려 1만배나 증가한 수치다.

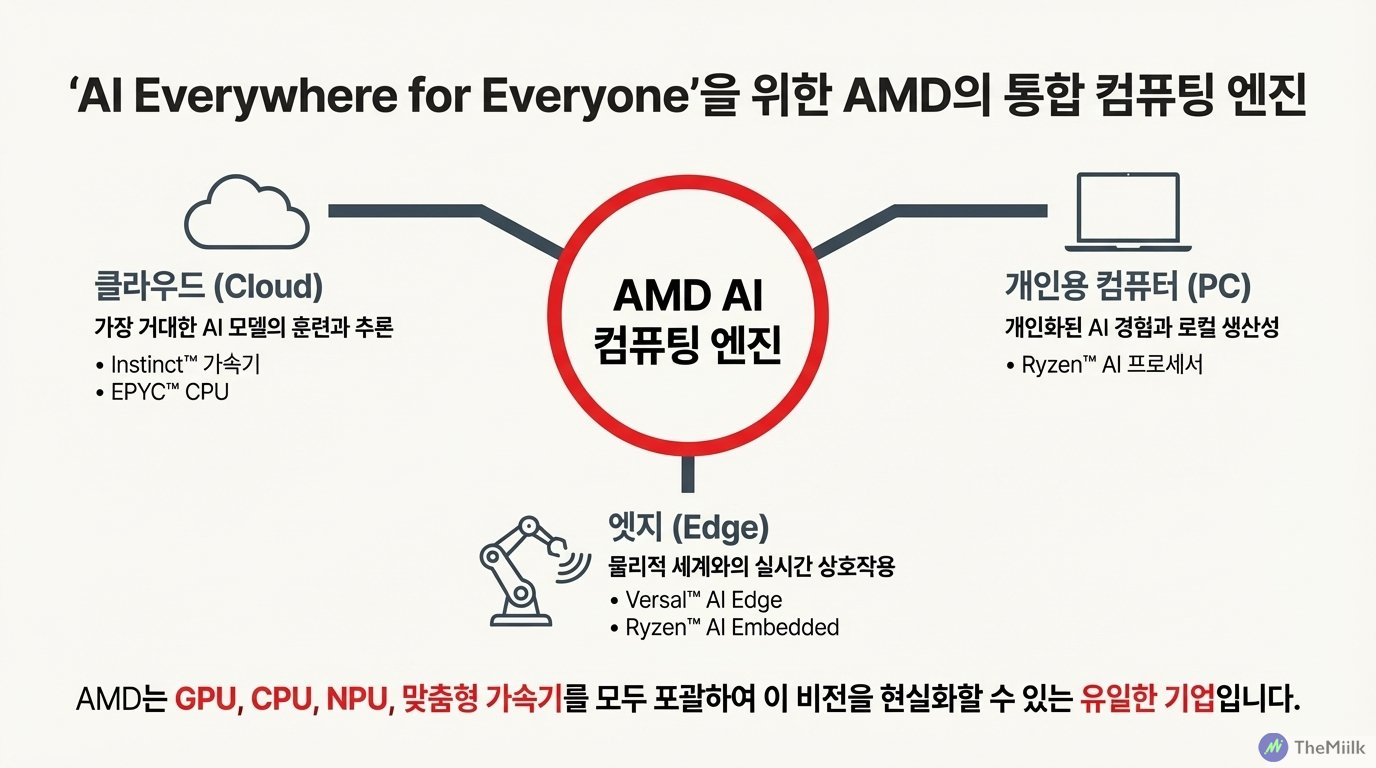

수 CEO는 "AI의 기반은 컴퓨팅"이라며 "AI를 모든 곳에 구현하려면 요타스케일 컴퓨팅이 필수"라고 강조했다. AMD는 이를 실현하기 위해 GPU, CPU, NPU, 그리고 적응형 컴퓨팅을 모두 보유한 유일한 기업으로서 클라우드에서 PC, 엣지까지 아우르는 풀 스택 솔루션을 제공할 계획임을 강조했다.

AMD가 요타스케일의 컴퓨팅 파워를 제시한 배경에는 AI 수요의 급격한 증가가 있다.

오픈AI의 챗GPT 출시 이후, AI 활성 사용자는 10억 명을 돌파했고 5년 내에는 50억 명으로 확대될 것이란 전망이다. 실제로 글로벌 컴퓨팅 능력은 2022년 약 1 제타플롭에서 2025년 100 제타플롭 이상으로 3년 만에 100배 증가했다. 향후 5년 동안 컴퓨팅 능력을 100배 더 증가시켜야 된다는 리사 수의 주장이 허황된 것이 아니라는 의미다.

이를 증명하듯 오픈AI의 그렉 브록만 사장은 기조연설에 참석해 AI가 '에이전트 워크플로우'로 진화하면서 컴퓨팅 병목이 심화되고 있다고 설명했다. 그는 "세상의 모든 사람을 위해 AI를 사용하게 되기를 바라지만 그 말은 수십억 개의 GPU가 필요하다는 뜻"이라며 현재 인프라의 한계를 드러냈다.

"칩 전쟁은 끝났다"...AMD, ‘3.2톤 헬리오스’로 AI 인프라 전쟁 선포

AMD가 제시한 문제는 명확하다. 현재의 컴퓨팅 인프라로는 이 수요를 감당할 수 없다는 것이다. 이제 AI는 단순 질의응답을 넘어 '에이전트 워크플로우'로 진화하고 있다. 컴퓨팅 파워가 이전과는 비교할 수 없을 정도로 커져야 한다는 의미다.

이는 AI 시장의 성장 동력이 '모델 혁신'에서 '인프라 확장'으로 이동하고 있음을 시사한다.

AMD의 대응 전략도 '확장'이다. 지금까지 개별 칩 성능 경쟁에 매달렸다면 이제는 규모 자체를 크게 확장한 랙 스케일의 통합 시스템으로 승부수를 던진 것이다.

AMD는 요타스케일의 컴퓨팅을 구현하기 위해 CES2026 무대에서 차세대 랙 스케일의 플랫폼인 '헬리오스(Helios)'를 공개했다. 헬리오스는 페이스북의 메타플랫폼과 공동 개발한 OCP 오픈 랙 와이드 표준 기반으로 설계됐고 무게는 약 3.2톤에 달한다.

차세대 '헬리오스' 플랫폼은 3200억 개 트랜지스터를 집적한 MI455X GPU와 최대 256코어의 베니스 CPU(Venice CPU), 그리고 800기가비트의 이더넷 네트워킹을 하나의 유기체처럼 통합했다. 규모가 커진만큼 성능도 향상됐다. 단일 랙은 2.9 엑사플롭스 성능을 제공하며, 이는 이전 세대 대비 추론 처리량에서 최대 10배나 향상된 수치다.

여기서 주목할 점은 메타와 공동 개발한 OCP(Open Compute Project) 표준 기반 설계다. 이는 단순한 기술 협력이 아니다. 하이퍼스케일러들이 엔비디아와 같은 단일 벤더에 대한 종속성을 피하려는 시장의 요구에 대한 전략적 대응이다. 클라우드 인프라 시장에서 '개방성'은 이제 필수 조건이 되고 있는 것이다.

엔비디아의 폐쇄적 CUDA 겨냥?...AMD, ‘개방 생태계’로 판 흔든다

하지만 AMD의 진짜 승부처는 하드웨어가 아니라 소프트웨어 생태계다.

AMD가 새로 발표한 '랙햄(Rackham)' 오픈 소프트웨어 스택은 기존의 생태계에서 이미 월 1억 회 이상 다운로드되는 주요 오픈소스 프레임워크인 파이토치(PyTorch)와 허깅페이스(Hugging Face) 등을 기본적으로 지원한다. 이는 개발자들이 기존의 도구를 그대로 AMD 하드웨어에서 사용할 수 있음을 의미한다.

이것이 무엇을 의미할까?

이는 엔비디아의 쿠다(CUDA) 생태계가 기술적으로 우위를 지니고 있음에도 그 폐쇄성으로 인해 피로감이 시장 참여자들 사이에서 누적되고 있음을 시사한다. AMD는 이런 시장의 암묵적 요구를 겨냥했다.

비디오 생성 AI 스타트업인 루마 AI의 사례는 이 전략이 시장에서 통하고 있음을 입증한다. 루마 AI는 자사의 추론 워크로드의 60%를 AMD CPU에서 실행하며 "복잡한 멀티모달 모델에서 최고의 총소유비용(TCO)을 달성했다"고 밝혔다. 루마 AI는 세계 최초 추론 비디오 모델 '레이 3(Ray 3)'를 통해 픽셀 생성을 넘어 물리 법칙과 인과 관계를 시뮬레이션하는 단계로 진화하고 있다.

또한 'AI의 대모'로 불리는 페이페이 리가 이끄는 월드 랩(World Labs) 역시 AMD MI325X 칩에서 3D 월드 생성 모델인 '마블(Marble)'을 구동하며 일주일 만에 4배의 성능 향상을 경험했다고 강조했다. 마블은 몇 개의 이미지만으로 탐색 가능한 3D/4D 세계를 생성하는 것으로 알려졌다.

AMD의 공격적인 전략은 계속된다. 리사 수는 2027년 출시 예정인 MI500 시리즈를 통해 4년간 AI 성능을 1000배 향상시키는 로드맵도 제시했다. 특히 AMD가 제시하는 개방성은 단순한 철학이 아니라 엔비디아의 폐쇄성에 지친 시장 참여자들의 마인드셰어를 확보하기 위한 실질적 무기가 되고 있다.

2000억 파라미터 PC 시대: AMD가 예고한 온디바이스 AI 혁명

AMD의 독특한 강점은 GPU, CPU, NPU, 적응형 컴퓨팅(FPGA)을 모두 보유한 유일한 기업이라는 점이다. GPU는 대규모 AI 모델 훈련과 병렬 연산에, CPU는 범용 연산과 데이터 전처리에, NPU는 PC와 모바일 기기에서의 저전력 AI 추론에, 적응형 컴퓨팅은 실시간 엣지 처리와 특수 워크로드 최적화에 각각 특화돼 있다.

이것이 무엇을 의미하는가.

이는 AMD가 클라우드부터 PC, 엣지 디바이스까지 각기 다른 요구사항을 맞춤형으로 충족시킬 수 있는 유일한 '풀 스택 컴퓨팅 엔진' 제공자로서의 입지를 다지고 있음을 의미한다.

PC 시장에서 AMD는 최대 2000억 개의 매개변수 모델을 로컬에서 구동할 수 있는 '라이젠 AI 할로' 플랫폼을 공개했다. 이는 개인 컴퓨터를 활용해 고가의 AI 클라우드 인스턴스에 의존하지 않고 대규모 모델을 수행할 수 있게 해, 온디바이스 AI 생태계 구축의 핵심 인프라가 될 전망이다.

물리적 AI 영역에서의 상황은 더 흥미롭다.

휴머노이드 로봇 개발사인 제너레이티브 바이오닉스는 "터치, 균형, 안전 루프 작동은 클라우드 접속까지 기다릴 수 없다"며 온디바이스 AI 생태계에서 AMD 엣지 플랫폼의 필수성을 강조했다. 우주 로켓 기업인 블루오리진은 AMD 버살 2를 도입해 2028년 달 착륙선 개발 일정을 수개월 단축한 것으로 나타났다. 극한의 엣지 환경에서도 신뢰성을 입증한 것이다.

헬스케어 분야에서도 AMD를 통한 AI 혁신은 가속화되고 있다.

신약 개발 기업인 앱사이(AppSci)는 AMD 컴퓨팅만으로 하루 100만 개 이상의 약물 후보를 스크리닝하고 있다. 또한 영국의 아스트라제네카는 생성 AI를 통해 신약 후보 전달 속도를 50% 향상시켰고 일루미나는 30억 개 글자로 구성된 게놈 데이터를 신속 처리해 정밀 의학을 실현하고 있다.

더밀크의 시각: 컴퓨팅 100배, 추론 100배…AI 인프라, 감당 가능할까?

AMD가 말하는 요타스케일의 AI 인프라 확장은 과연 실현 가능한 이야기인가?

2021년의 '챗GPT 모멘트' 이후 시장은 실제로 믿을 수 없는 수준의 AI 컴퓨팅을 요구하기 시작했다. 컴퓨팅 파워는 AI 인프라의 확산과 함께 3년 만에 100배 수준으로 증가했다.

AMD가 이야기하는 요타스케일 선언이 합리적으로 보이는 이유다.

이는 AI 시장의 경쟁 축이 '모델 우위'에서 '인프라 확보'로 계속 진행되고 있음을 시사한다. 여전히 AI 기업들은 더 나은 알고리즘과 더 큰 파라미터 모델 개발에 주력하고 있다. 하지만 2024년 이후 병목은 기술보다는 컴퓨팅 자원이 되고있고 더 나아가 전력 인프라까지 확산되고 있다.

오픈AI의 브록만이 "수십억 개의 GPU가 필요하다"고 말한 것은 단순히 수사가 아니라 실제 수요 추정치라는 점을 주목해야 한다. 문제는 AI의 대중화를 촉발할 수 있는 '에이전트 워크플로우'가 확산되면 현재의 추론 수요는 다시 100배 이상 증가할 것이라는 점이다.

문제는 이런 수요를 충족할 수 있는 공급이 존재하지 않는다는 점이다.

AI는 단순히 기술의 발전만으로 충족할 수 있는 것이 아니다. 막대한 리소스와 고도의 인프라가 필요하다. AI 인프라는 이제 단순히 기업의 투자 전략이 아닌 국가 안보 전략의 영역으로 확장됐다.

AI 데이터센터 전력 과부하로 인한 샌프란시스코의 연쇄 정전 사태는 현재 이 사회가 보유하고 있는 기존의 전력망과 인프라로는 AI의 발전 속도를 따라가지 못하고 있음을 시사한다.

AMD의 리사 수가 이야기하는 요타스케일은 불가능의 영역이 아니다. 문제는 가능한 이야기이기 때문에 더 무서운 현실이 될 수 있다는 사실이다. AI 시대의 권력 구조가 '소프트웨어 알고리즘'에서 '하드웨어 인프라'로 이동하고 있다는 사실은 부인할 수 없다. 하지만 과연 AI 인프라가 요구하는 컴퓨팅 파워, 전력, 그리고 속도를 우리가 감당해낼 수 있는가는 별개의 문제다.